“Fault Avoidance vs. Fault Tolerance: TestingDoesn’t Scale”软件规划应该能够容错,而不是尽力的经过许多测验而防止过错。因为软件的杂乱度越来越高,代码量越来越大,会导致软件质量下降。而模块化规划不能削减杂乱度,一起测验也掩盖不到一切杂乱的,彼此相关的特性。

中别的一篇“The Cost of a Cloud: Research Problems in DataCenter Networks”的论文,提出两种建造数据中心的思路。一种是建造10万台+的超大规划数据中心,有更好的性价比,但会有资源碎片等副作用。别的一种是围绕着终究用户树立一系列小型数据中心,会有好的拜访延时,但数据中心之间的互联会十分贵重。在1999年

中一篇标题为“Fault Avoidance vs. Fault Tolerance: TestingDoesn’t Scale”的论文观念以为:软件规划应该能够容错,而不是尽力的经过许多测验而防止过错。因为软件的杂乱度越来越高,代码量越来越大,会导致软件质量下降。而模块化规划不能削减杂乱度,一起测验也掩盖不到一切杂乱的,彼此相关的特性。

中别的一篇“The Cost of a Cloud: Research Problems in DataCenter Networks”的论文,提出两种建造数据中心的思路。一种是建造10万台+的超大规划数据中心,有更好的性价比,但会有资源碎片等副作用。别的一种是围绕着终究用户树立一系列小型数据中心,会有好的拜访延时,但数据中心之间的互联会十分贵重。接下来咱们看AWS是怎样做的……

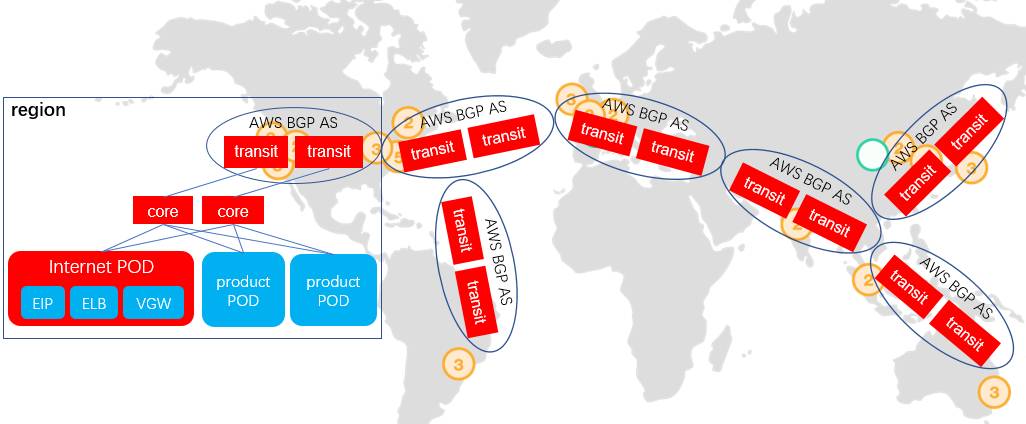

中的黄色符号能够看出,其围绕着客户在全球树立了16个资源阻隔的Region,每个Region包括2~3个Availability Zone(可用区)。Availability Zone为一个数据中心群,包括1~6个6万+规划的超大数据中心。Availability Zone间间隔一般为30~100公里,以确保风火水电的阻隔。

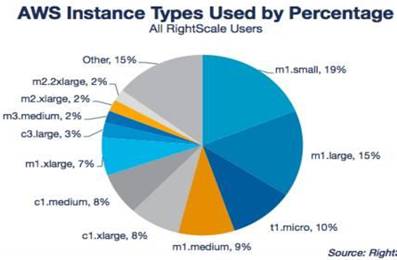

AWS云主机规范核算饼图,咱们能够看到1核~2核规范的云主机是干流,占有了近70%的份额。依照惯例AWS物理主机的2个Intel Xeon E5 12 core的装备来看,均匀每个物理机上应该承载12个左右的云主机数量。而6万台的数据中心应该包括72万台云主机。依照每Availability Zone均匀包括3个数据中心算,AWS在每个Region具有可高质量互通的7.5个6万+的数据中心群,其间可布置45万+的物理机,承载540万+的云主机,这是个十分巨型的处理计划。AWS数据中心间的网络规划实践

先从图表4看其Region间互联规划,其经过各个Region自有的BGP AS域构建了一个100Gb带宽的举世互联网络,以支撑其全球级服务办理面互通,和AWS BGP AS内的公网IP之间互通流量。相关于公共互联网,有低延时高可用的优势。但关于每个Region内近540万+云主机来说,每个云主机的均匀带宽不到24bps。

再从图表5看其Region内网络互联规划。Region内的各个数据中心,经过两个独立的transit节点接入上面讲的Region间骨干网,以确保链路冗余性。Region内的2~3个AZ间确保全互连,互联链路带宽到达25Tbps。依照之前推论的AZ内包括180万+个云主机核算,每个云主机均匀有14Mbps的带宽。每个AZ内的1~6个数据中心之间确保全互联,互联链路到达102Tbps,均匀每个云主机具有178Mbps的链路带宽。

在Fault Avoidance上,AWS提出了Region与AvailabilityZone的概念,帮忙客户构建高可用运用。Region为完全阻隔的两个资源池,而Availability Zone是可互通的、但风火水电阻隔的资源池。客户将服务布置到不同的Region与Availability Zone中,运用负载分管完结Active-Active高可用,以防止或许的单点毛病。Availability Zone在其悉尼Region毛病中经过了查验,在1个AZ完全中止服务时,别的一个AZ能够供给完好的服务,防止客户运用完全不行服务。在数据中心规划上 ,AWS挑选了两种计划的结合。

依照地理位置树立独立的、45万+物理机的超大规划数据中心集群,既确保了规划效应的高性价比,又完结了终究客户杰出的网络体会。独立的数据中心集群间只坚持较小的互联带宽,防止大范围网络互联的高出资。数据中心集群内,在数据中心间、以及数据中心内规划了很高的互联带宽,完结资源池的一致SLA体会。2云主机规划

InternationalConference on Data Engineering,一篇名为 “cloud computing imperatives”的论文提出,大型的数据中心比中型数据中心能够供给7.1倍的网络性价比、5.7倍的存储性价比、以及高达15.7倍的办理本钱性价比。一起在核算才干本钱日益下降的布景下,开展大型的数据中心,才干处理数据传输高延时与能耗缺乏的基础设施瓶颈。在2008年的

InternationalConference on Data Engineering,一篇名为 “cloud computing imperatives”的论文提出,大型的数据中心比中型数据中心能够供给7.1倍的网络性价比、5.7倍的存储性价比、以及高达15.7倍的办理本钱性价比。一起在核算才干本钱日益下降的布景下,开展大型的数据中心,才干处理数据传输高延时与能耗缺乏的基础设施瓶颈。AWS云主机网络规划实践

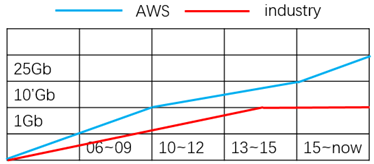

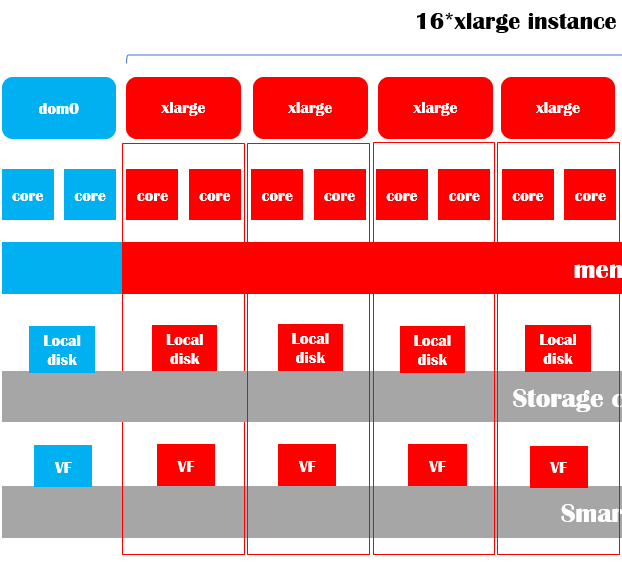

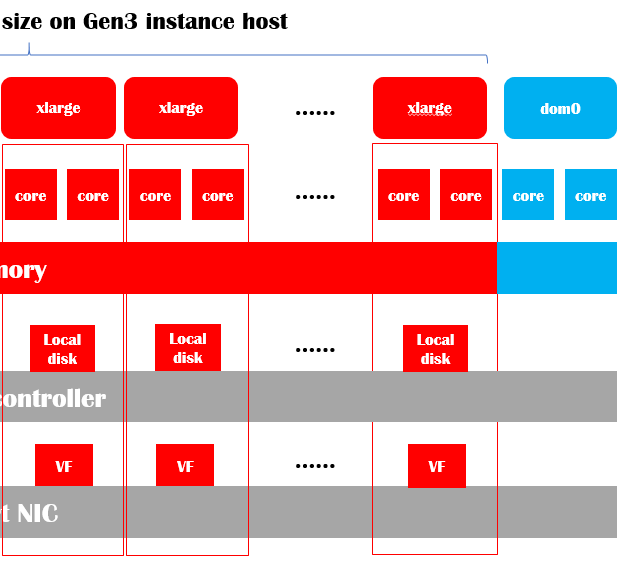

在2010年的cg1实例上清晰运用10Gb网络,到2015年的x1实例上清晰运用25Gb的网络。更高的数据中心内网络带宽,不只给每个云主机供给更多的带宽资源,最重要的会下降途径上一切网络设备的行列深度,然后得到更低的东西向流量网络延时。AWS在2011年左右引进了10Gb的智能网卡(驱动兼容Intel的ixgbevf,出产厂商不详),并对一切规范的云主机规范敞开,供给一般vif与SRIOV VF两种接口(如图表7)。随后在2015年随x1机型推出了25Gb的智能网卡(运用自有ENA驱动,收买的annapurna规划)。

智能网卡承当了本来物理机内虚拟交换机的路由、contrack匹配、ACL过滤、VTEP查表、MAC代答、tunnel树立等作业负载,大幅度下降了网络延时,进步了网络吞吐量。一起硬件完结了虚拟机粒度的、严厉的带宽以及五元组流的QoS,确保根本一切类型以及规范的云主机都有安稳可猜测的网络功用。

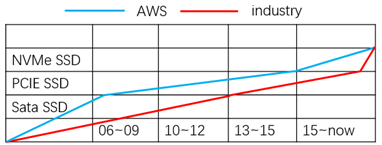

看,AWS运用存储介质的战略也相比照业界急进,从2007年开端的c1实例运用了SATA口的SSD,2015年在x1实例上运用了PCIE SSD(在2007年~2015年之间也在少数机型上运用了PCIE SSD,应该是保护困难抛弃了,x1实例因为SATA SSD的IOPS才干不行),在2016年末的p2实例上正式推出了NVMe SSD。比业界的挑选全体快1~4年。当时NVMe SSD的运用上时刻点挨近,这个是因为存储技能开展比网络慢许多。

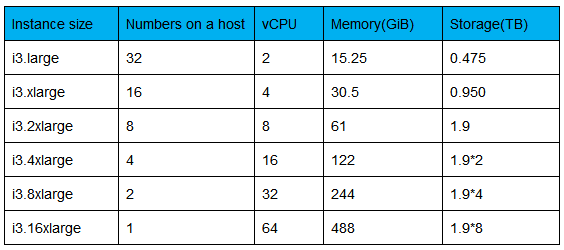

作为存储介质,但从下表能够看出,AWS最新推出的i3实例的物理机挂载8个1.9T的NVMe盘,能够一起承载32个规范的实例,而且能够确保这些实例的存储SLA。笔者估测估测其在i3实例物理机上运用了相似JBOF中的NVMe controller,将云主机的最多32个NVMe SSD盘的后端卸载到该controller卡上。一起NVMe controller需求对挂载的8个NVMe SSD进行了条带化,然后完结1个NVMe盘一起供给给两个云主机运用,而且有严厉的SLA确保。

在云主机规划的实践看,其完全恪守了前面论文的理论,经过大型数据中心的规划效应来进步资源池的质量。经过全网运用更高带宽的网络技能,以及主机端的智能网卡,完结了比业界大大下降的云主机网络时延。比业界更早的运用更高功用的存储介质,而且经过新的存储卸载技能,大幅度的下降了存储时延,而且进步了存储密度。从前面图表3中RightScale的核算图咱们能够看出,AWS环境中80%以上的实例是小规范的。越来越多的客户倾向与开发微服务架构的运用,经过简略的高扩展的运用架构替代以往杂乱的运用架构。AWS的云主机规划战略很明显,在确保整个资源池的核算、网络、存储功用优势以外,还要确保有才干供给满意小的资源颗粒粒度,一起确保这些颗粒有SLA的确保。(

)从经过智能网卡完结了高密度虚拟网卡,以及准确的QoS操控,确保云主机的网络质量可猜测。到运用新的存储卸载技能来供给高密度的虚拟NVMe设备,以及准确的QoS操控,确保云主机的存储质量可猜测。咱们看到了其为客户供给细粒度资源的思路。

IEEEInternational Conference on Data Engineering,名为“Key Challenges inInformation Processing”的论文提出了大规划运用运营的几个应战。软件和人为因素是毛病的最大原因,而不是硬件设备自身的毛病。安全开支只要0.0025%,但常常会产生数据丢掉、运用被病毒感染、以及不安全的体系装备。开发者更热衷于优化运用部分功用,而不是进步运用的扩展性,但扩展性好的其实简略架构的运用,运转在不需求人员运维的大型集群上作用会更好。在2002年的

IEEEInternational Conference on Data Engineering,名为“Key Challenges inInformation Processing”的论文提出了大规划运用运营的几个应战。软件和人为因素是毛病的最大原因,而不是硬件设备自身的毛病。安全开支只要0.0025%,但常常会产生数据丢掉、运用被病毒感染、以及不安全的体系装备。开发者更热衷于优化运用部分功用,而不是进步运用的扩展性,但扩展性好的其实简略架构的运用,运转在不需求人员运维的大型集群上作用会更好。在2009年的

,上,一篇名为“Data CenterNetworks Are in my Way”的论文中提出,传统的网络设备没有像x86服务器架构相同有敞开的、规范的架构。运营商无法运用一套OSS体系,对局点内的各类设备进行办理,需求办理员手艺进行保护。在2009年的

,上,一篇名为“Data CenterNetworks Are in my Way”的论文中提出,传统的网络设备没有像x86服务器架构相同有敞开的、规范的架构。运营商无法运用一套OSS体系,对局点内的各类设备进行办理,需求办理员手艺进行保护。AWS云主机服务规划实践

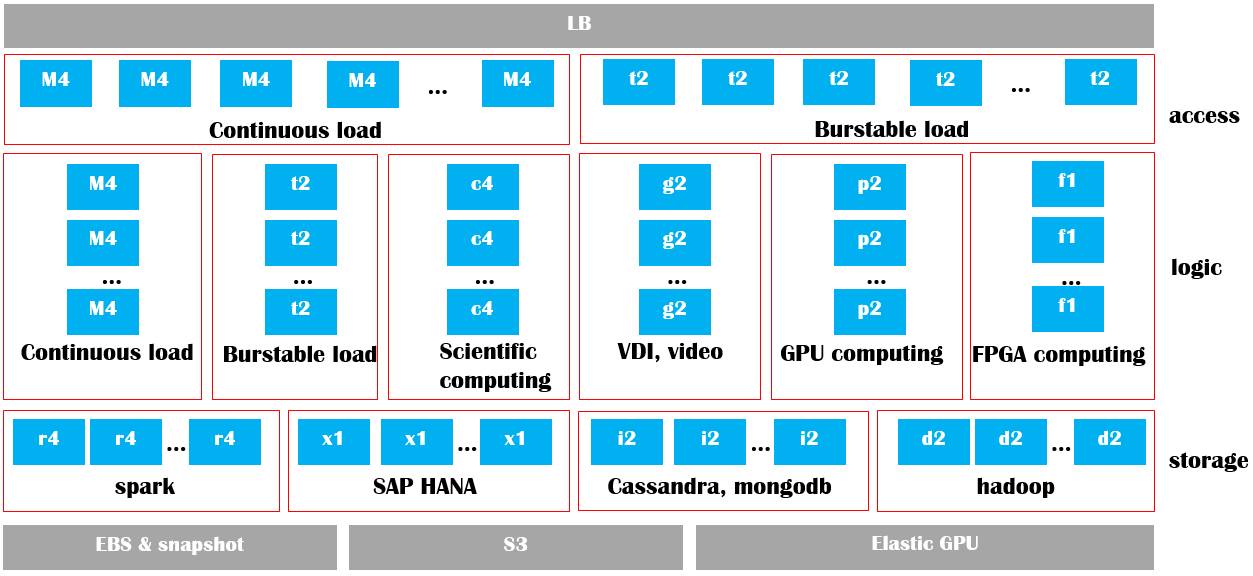

AWS供给了通用云主机、高功用云主机、GPU加快云主机、FPGA加快云主机、存储优化云主机、内存优化云主机等多种云主机规范。用户能够经过其运转一套包括接入、核算、数据落地的完好的运用仓库,一起习惯一般核算、HPC、DNN等各种场景。一切的云主机服务均经过线上console或许API注册,客户挑选好相应的云主机规范后,即买即用,用完即走。不需求关怀资源集群的运维、安全加固、设备优化等。当然这个在今日很简略了解,但其在2006年,机房保管才是干流商业形式的时分,挑选

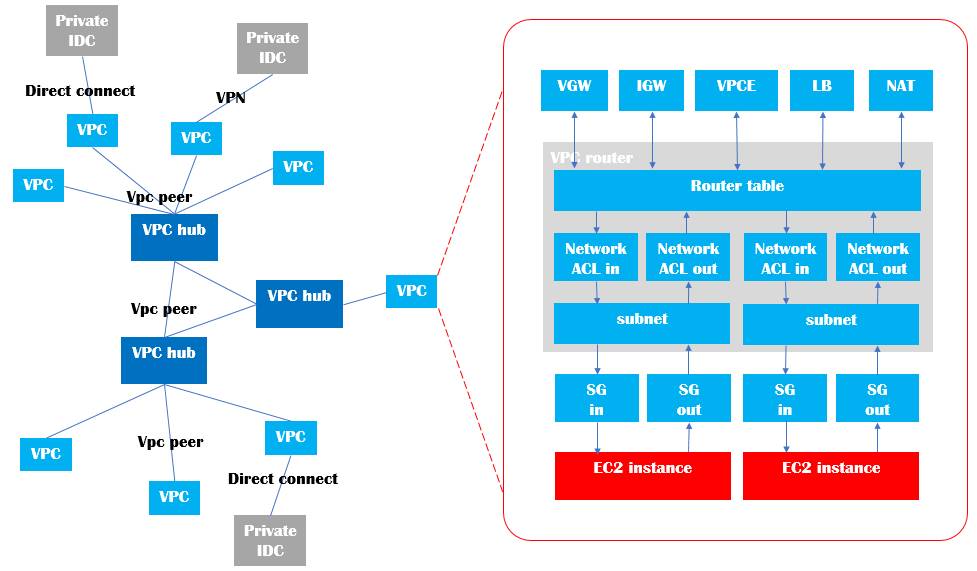

VPC在前一段时刻炒的炽热,各个大厂均出来讲自己的完结以及优势。因为热门起源于租户云主机阻隔,所以VPC的评论也限制到阻隔的特性。就笔者对AWS的了解,其提出VPC的概念首要意图是为了租户自助办理自己云网络中的各个网元,完结东西、南北向网络流量的装备。

其建筑大规划的数据中心,并优化数据中心的运维质量与本钱、进步资源运用功率、进步全体的安全性、完结数据中心的高扩展性。终究经过一致的API与console作为界面,运用自助的云服务屏蔽底层硬件差异,终究将数据中心才干供给给客户。4云核算究竟是什么

Twilio CEOJeff Lawson的界说,笔者以为十分有道理。Jeff以为在核算范畴曾经有两个浪潮,第一个浪潮是以Oracle为代表的公司控制。在这个阶段,是企业的IT部分担任购买软件然后布置办理,以供企业的职工运用。

,企业的出售、营销或许财务部分自己决议购买软件服务,由IT部分帮忙办理。现在进入了第三个浪潮年代,这个浪潮是由AWS所控制的。软件企业能够越过IT部分和事务部分,把他们的技能直接卖给在企业中担任构建运用程序的程序员。

Jeff从软件开发者的视点生动的描绘了软件职业的演进进程,在功用交给要求越来越快的布景下,因为软件功用的堆积,软件的体积越来越大,杂乱度越来越高,一起软件的质量也越来越难以确保。如图表13,软件开发形式开端从传统的瀑布流形式转化为今日的微服务形式。杂乱的单体式软件,拆解为一组简略但高扩展服务。大规划的开发团队,拆解为灵敏独立的开发小组。长达半年到1年的交给周期,分解为以周为单位的快速迭代。完全的D/O别离的帮忙形式,因为软件的微服务化,软件的事务运维与开发团队交融,形成了新的DevOps形式。

开发形式的演进,对基础设施的要求也在改变。从运用几台高配的服务器布置事务,改变为需求1个,乃至数个低配集群布置,完结各个模块的资源阻隔,以及整个事务的高可用。关于有自建数据中心的大型公司来说,或许不是问题,但关于中小型公司来说,这或许是不或许的使命。尤其是关于一些to C的事务,增加曲线年来规划基础设施的建造,在事务远景还不明亮的时分或许是个笑话。

▶经过其数据中心的巨型体量,运用各种最新的技能进步了资源的网络、存储功率,处理了功耗问题,一起下降了运维、安全等运营本钱。

▶为满意客户的不同核算负载,引进高功用核算、GPU、FPGA等技能,并经过小颗粒的资源粒度,经过一致、可编程的云服务形式供给给客户。

▶终究为了完结客户搬家的作业,供给了一系列搬家东西、笔直处理计划、服务布置东西、习惯新基础设施架构的中间件。

▶经过其数据中心的巨型体量,运用各种最新的技能进步了资源的网络、存储功率,处理了功耗问题,一起下降了运维、安全等运营本钱。

▶为满意客户的不同核算负载,引进高功用核算、GPU、FPGA等技能,并经过小颗粒的资源粒度,经过一致、可编程的云服务形式供给给客户。

▶终究为了完结客户搬家的作业,供给了一系列搬家东西、笔直处理计划、服务布置东西、习惯新基础设施架构的中间件。

当然这些到现在,也许是每个云核算工程师的知识,但在2006年AWS开端供给云核算服务的时刻点,仅有学术界的理论,工程上仍然是无人区。AWS在云核算的巨额投入,这是一场有革命性的、英勇的赌博。终究在2015年,才终究证明了这次技能革命是成功的。

一切的租户,也便是软件开发者,以及基础设施供给者都是参与者。软件开发者开发、运营原生的云运用,并对基础设施提出新的需求。基础设施供给者不断的进步资源池全体的扩展性、功率,并下降其本钱。一起确保单个资源的小颗粒,以及办理可编程性。好像芯片渠道Intel将芯片技能平等的提交给硬件集成商、通讯管道渠道华为将通讯技能平等的提交给电信运营商、手机软件渠道苹果appstore将客户无差别提交给软件开发者、即时通讯渠道腾讯将衔接提交给广阔终究用户。云核算基础设施渠道将资源池功率/本钱比,无差别的提交给云核算运用开发者,运用开发者的出资终究从基础设施变更到运用开发自身,使云核算分工更清晰,决议计划链条完结闭环迭代式开展。